YAYI大模型学习资源汇总 - 基于LlaMA 2的中文多领域大语言模型

1451 2025-01-03 00:00:00

YAYI大模型学习资源汇总

YAYI是一个基于LlaMA 2的中文多领域大语言模型,由中科闻歌研发团队开源。本文汇总了YAYI的相关学习资源,帮助读者快速了解和使用这个模型。

项目简介

YAYI是一个在百万级高质量中文领域数据上微调的大语言模型,覆盖了媒体宣传、舆情分析、公共安全、金融风控、城市治理等多个领域。模型具有以下特点:

基于LLaMA 2和BLOOM系列模型训练增强了中文基础能力和领域分析能力支持多轮对话和部分插件能力经过大量用户测试,提升了性能和安全性模型下载

YAYI提供了以下几个版本的模型权重:

YAYI-7BYAYI-7B-Llama2YAYI-13B-Llama2可以直接从Hugging Face下载使用。

快速使用

以下是使用YAYI-7B模型进行推理的示例代码:

from transformers import AutoTokenizer, AutoModelForCausalLM, GenerationConfigimport torchyayi_7b_path = "wenge-research/yayi-7b"tokenizer = AutoTokenizer.from_pretrained(yayi_7b_path)model = AutoModelForCausalLM.from_pretrained(yayi_7b_path, device_map="auto", torch_dtype=torch.bfloat16)prompt = "你好"formatted_prompt = f"<|System|>: A chat between a human and an AI assistant named YaYi. YaYi is a helpful and harmless language model developed by Beijing Wenge Technology Co.,Ltd. <|Human|>: {prompt} <|YaYi|>:"inputs = tokenizer(formatted_prompt, return_tensors="pt").to(model.device)eos_token_id = tokenizer("<|End|>").input_ids[0]generation_config = GenerationConfig( eos_token_id=eos_token_id, pad_token_id=eos_token_id, do_sample=True, max_new_tokens=100, temperature=0.3, repetition_penalty=1.1, no_repeat_ngram_size=0)response = model.generate(**inputs, generation_config=generation_config)print(tokenizer.decode(response[0]))模型微调

YAYI项目提供了完整的微调代码,支持以下几种微调方式:

指令数据全参数微调指令数据LoRA微调多轮对话数据全参数微调多轮对话数据LoRA微调微调数据格式和运行命令可参考GitHub仓库。

训练数据

YAYI基于中科闻歌百万级高质量领域指令数据集训练而来,开源了5万条训练数据,可在Hugging Face数据仓库下载。数据集涵盖金融、安全、舆情、媒体等领域。

更多资源

YAYI项目GitHub仓库YAYI模型在线体验技术报告论文通过以上资源,相信读者可以快速上手YAYI大模型,并将其应用到实际项目中。YAYI作为一个开源的中文大语言模型,未来还会持续更新,欢迎大家关注和使用!

热门资讯

-

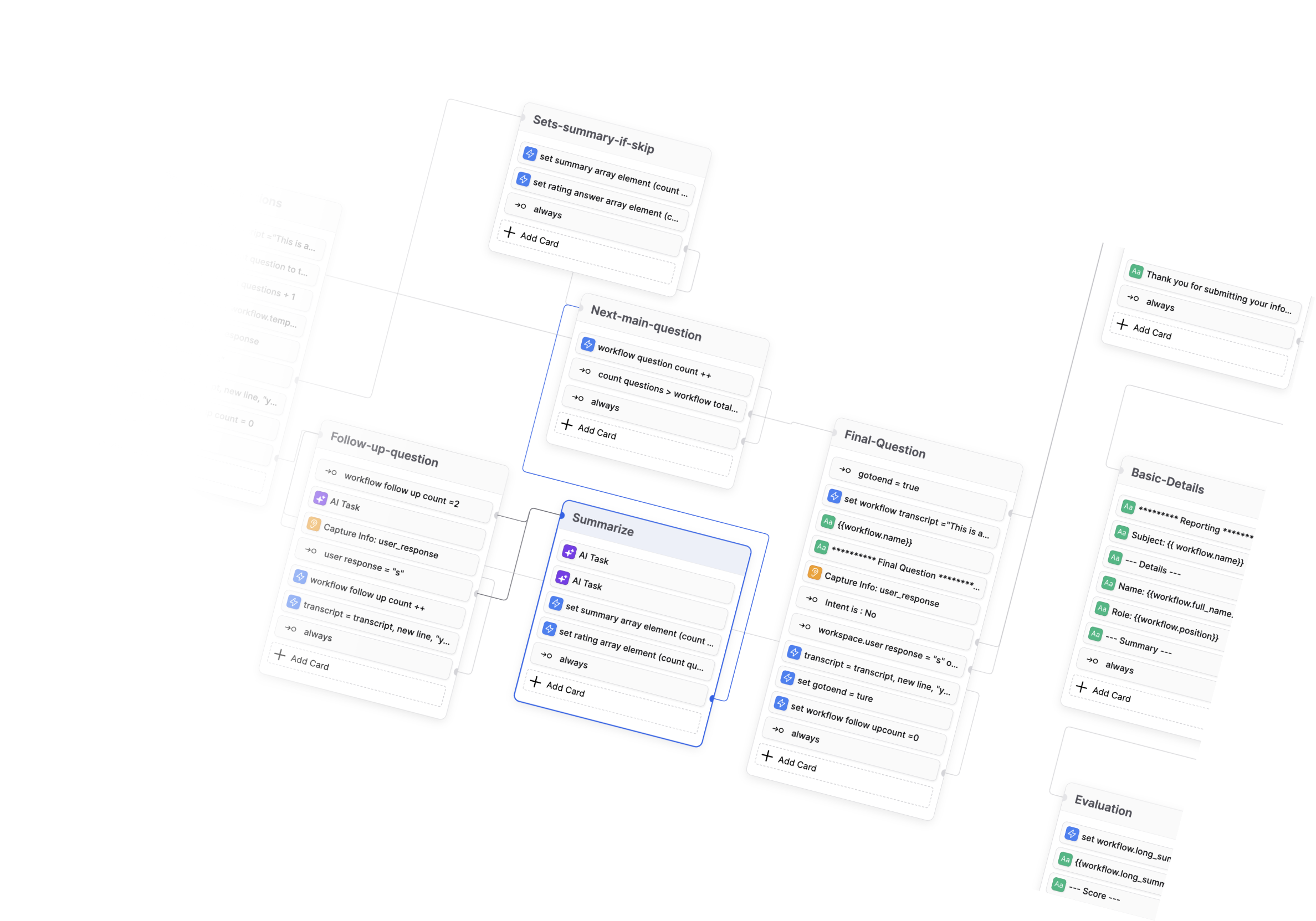

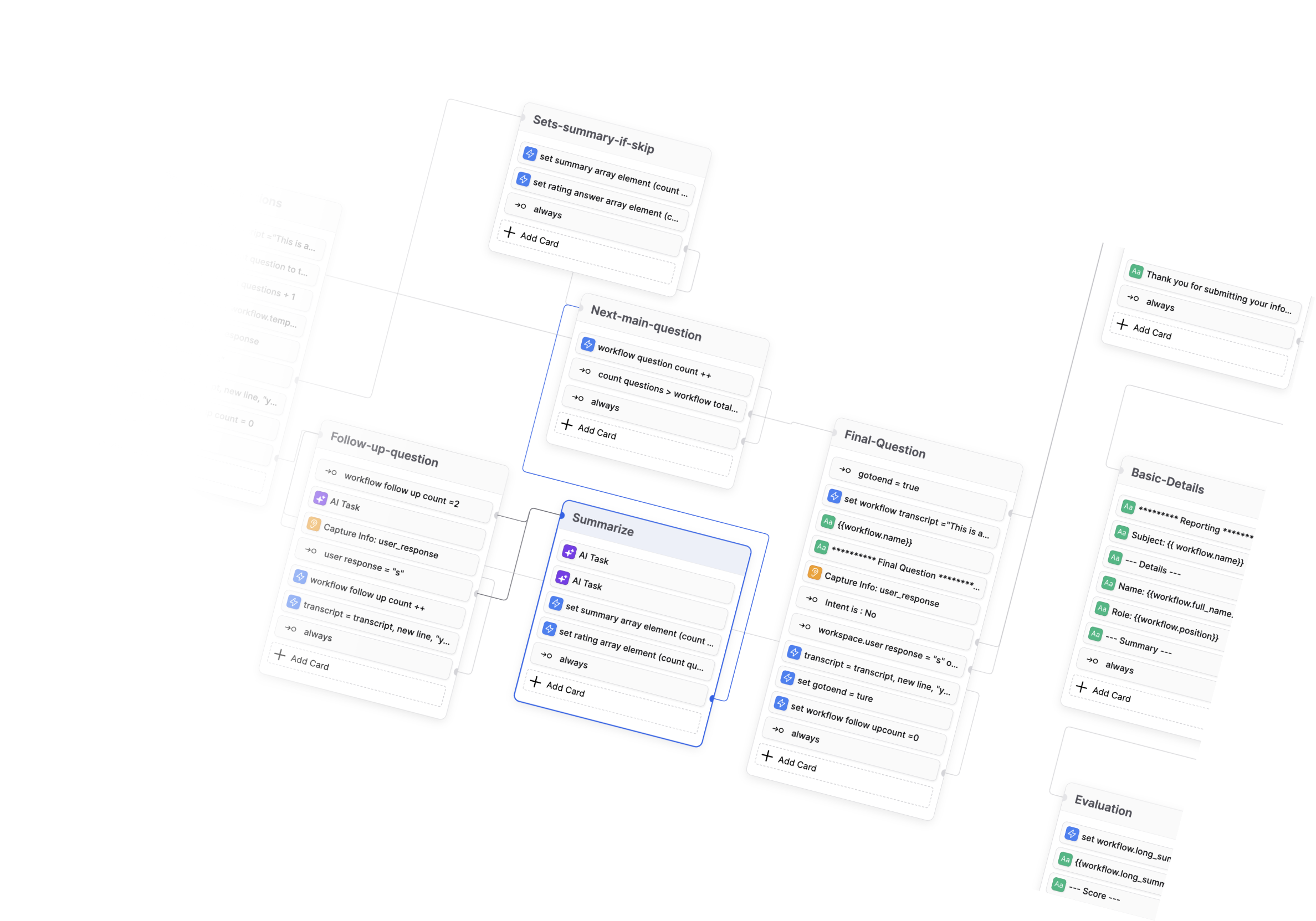

- Botpress学习资料汇总 - 开源对话式AI平台

- 1942 2024-12-16 16:31:42

-

- BibiGPT-v1: 革命性的AI音视频内容一键总结工具

- 1857 2024-12-19 05:49:31

-

- Ethora: 开源 Web3 社交平台引擎

- 1164 2025-01-06 17:56:26

-

- DouZero: 基于自我对弈深度强化学习的斗地主AI系统

- 609 2024-12-19 02:10:32

-

- 开源数据工程项目精选:打造现代数据基础架构

- 897 2025-01-06 16:16:54

-

- AI也能刷短视频了?!清华大学最新发布短视频理解模型,含图像文本音频多模态理解

- 589 2024-12-31 16:07:01

-

- Diffree:最新模型实现文字指令修改图片!!这下修图变得更简单了

- 1599 2024-12-31 16:27:01

-

- 北大团队最新发布全景3D技术!只需一张图片和一段话就能生成全景3D场景

- 1941 2024-12-31 16:46:55

-

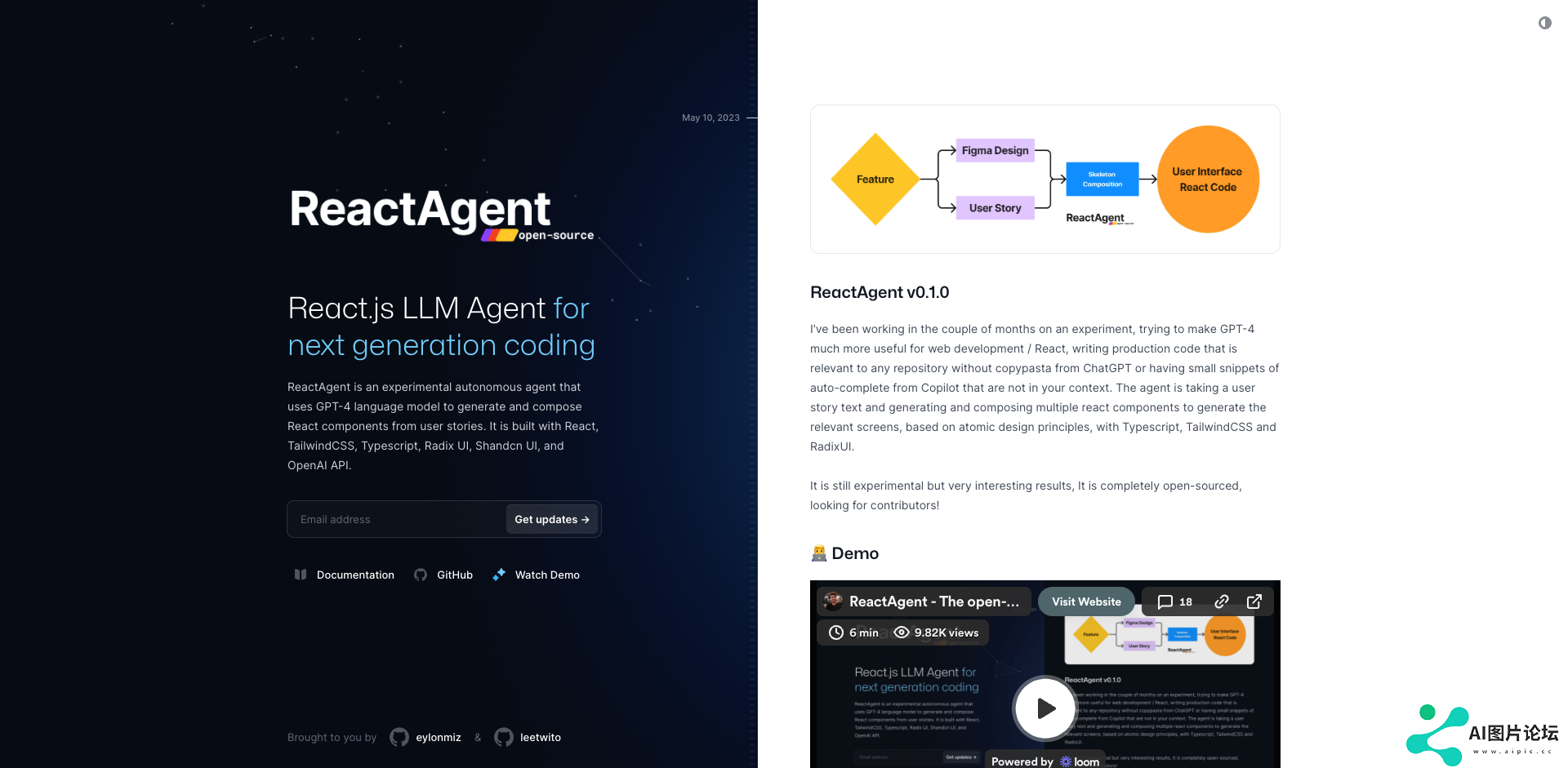

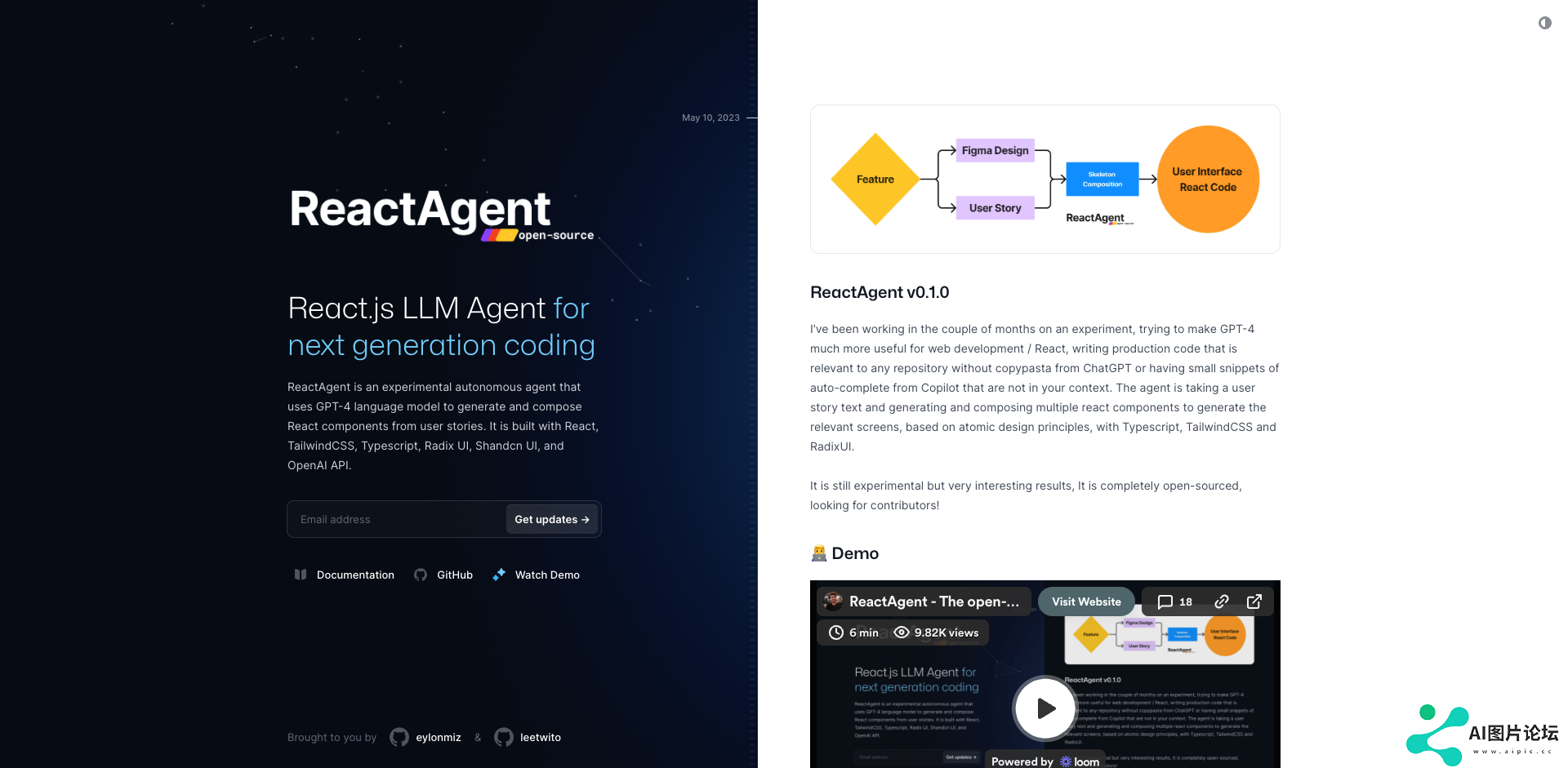

- React Agent 学习资料汇总 - 开源 React.js 自主 LLM 代理

- 1907 2025-01-03 17:08:43

-

- Mojo编程语言学习资料汇总 - 兼具Python语法和系统级性能的AI编程语言

- 1121 2025-01-06 14:37:19

相关常用工具

查看更多- 1 cheetah 284

- 2 SUPIR 818

- 3 Conference-Acceptance-Rate 226

- 4 DouZero 1835

- 5 GodMode 955

- 6 MeloTTS 294

- 7 codefuse 215

- 8 腾讯云 AI 代码助手 1149

- 9 CodeGeeX 1836