VisualGLM-6B 学习资料汇总 - 开源多模态中英双语对话模型

115 2025-01-03 00:00:00VisualGLM-6B简介

VisualGLM-6B是由清华大学开源的一个支持图像、中文和英文的多模态对话语言模型。它基于ChatGLM-6B语言模型,通过训练BLIP2-Qformer构建起视觉模型与语言模型的桥梁,整体模型共78亿参数。

VisualGLM-6B具有以下特点:

支持图像、中文和英文的多模态对话基于ChatGLM-6B,具有62亿参数通过BLIP2-Qformer连接视觉模型和语言模型在30M中文和300M英文图文对上进行预训练支持低资源设备部署,INT4量化后最低只需6.3G显存官方资源

GitHub仓库: https://github.com/THUDM/VisualGLM-6BHugging Face模型: https://huggingface.co/THUDM/visualglm-6b技术报告: https://arxiv.org/abs/2103.10360使用教程

安装依赖:pip install -r requirements.txt使用Transformers加载模型:from transformers import AutoTokenizer, AutoModeltokenizer = AutoTokenizer.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True)model = AutoModel.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True).half().cuda()image_path = "your_image_path"response, history = model.chat(tokenizer, image_path, "描述这张图片。", history=[])print(response)运行Demo:python web_demo.py # 网页版Demopython cli_demo.py # 命令行Demo模型微调

VisualGLM-6B支持以下几种微调方式:

LoRAQLoRAP-tuning微调示例代码:

bash finetune/finetune_visualglm.sh部署

命令行部署: python cli_demo.py网页部署: python web_demo.pyAPI部署: python api.py模型量化

model = AutoModel.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True).quantize(8).half().cuda()相关项目

XrayGLM: 基于VisualGLM-6B的X光诊断问答模型StarGLM: 基于VisualGLM-6B的天文图像问答模型总结

VisualGLM-6B作为一个开源的多模态对话模型,为研究者和开发者提供了丰富的学习和应用资源。通过本文的介绍和资源汇总,相信读者可以快速上手使用VisualGLM-6B,并根据自己的需求进行进一步的开发和优化。

热门资讯

-

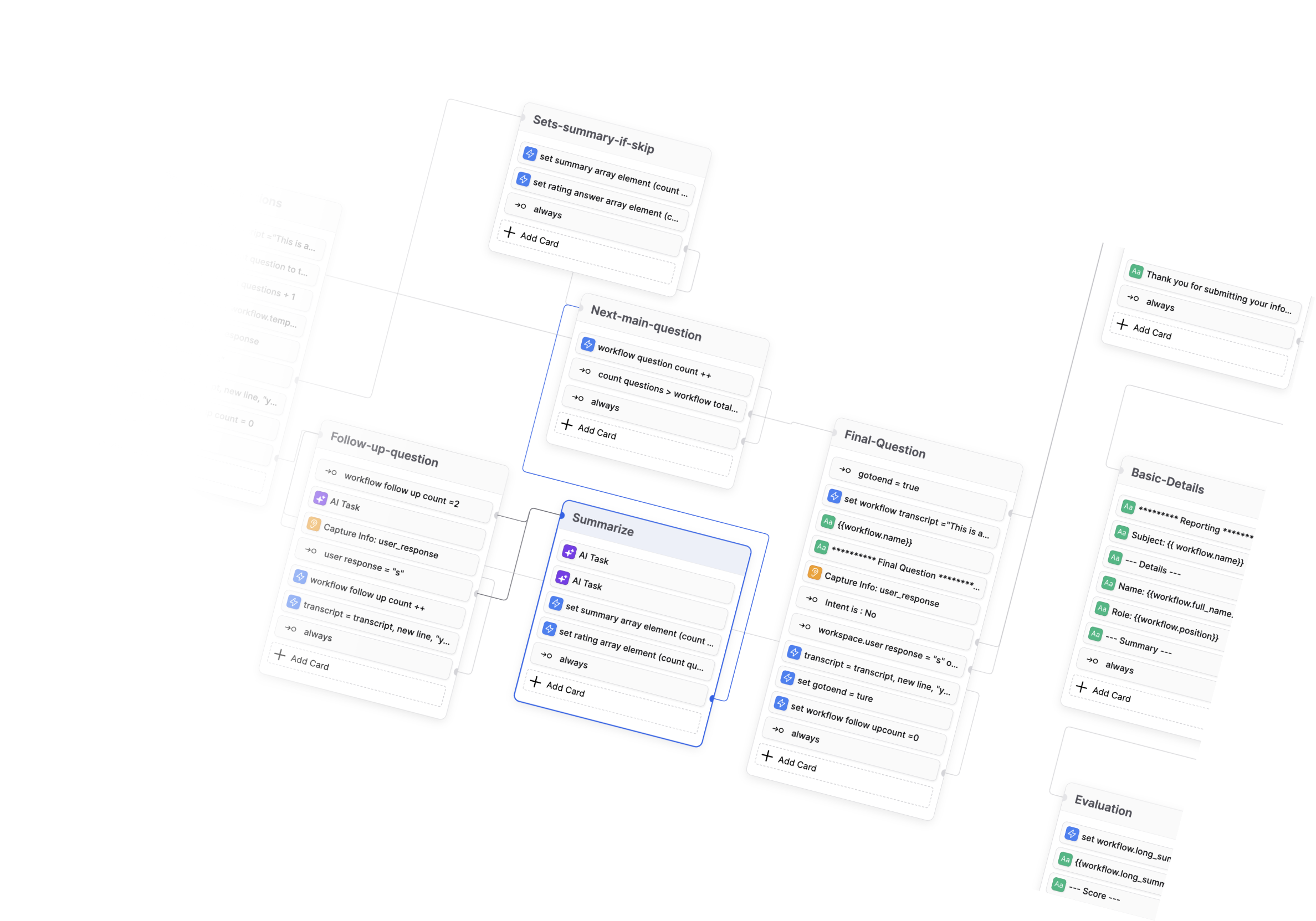

- Botpress学习资料汇总 - 开源对话式AI平台

- 1204 2024-12-16 16:31:42

-

- BibiGPT-v1: 革命性的AI音视频内容一键总结工具

- 1467 2024-12-19 05:49:31

-

- Ethora: 开源 Web3 社交平台引擎

- 1483 2025-01-06 17:56:26

-

- DouZero: 基于自我对弈深度强化学习的斗地主AI系统

- 785 2024-12-19 02:10:32

-

- 开源数据工程项目精选:打造现代数据基础架构

- 1361 2025-01-06 16:16:54

-

- AI也能刷短视频了?!清华大学最新发布短视频理解模型,含图像文本音频多模态理解

- 1807 2024-12-31 16:07:01

-

- Diffree:最新模型实现文字指令修改图片!!这下修图变得更简单了

- 1091 2024-12-31 16:27:01

-

- 北大团队最新发布全景3D技术!只需一张图片和一段话就能生成全景3D场景

- 626 2024-12-31 16:46:55

-

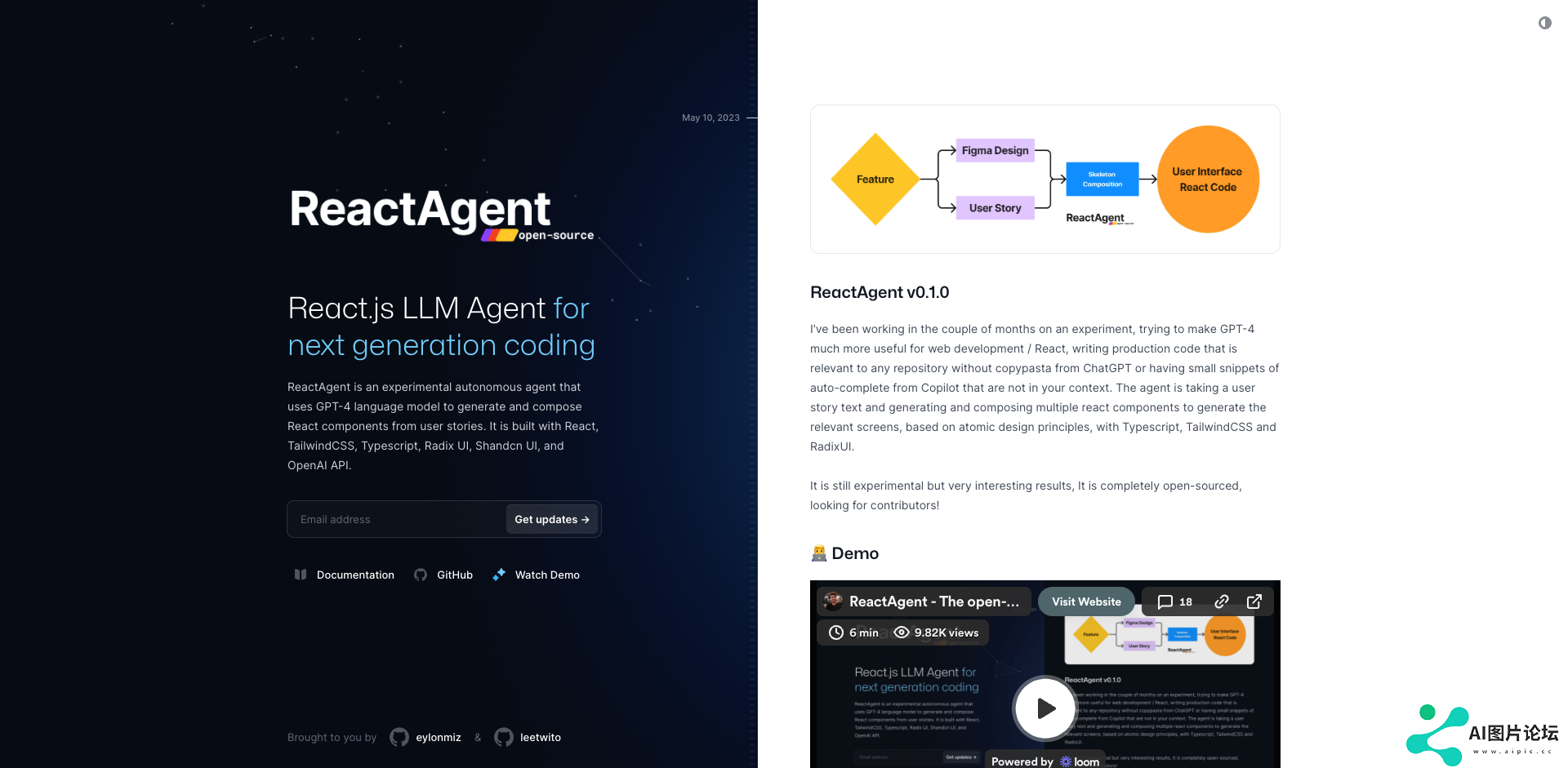

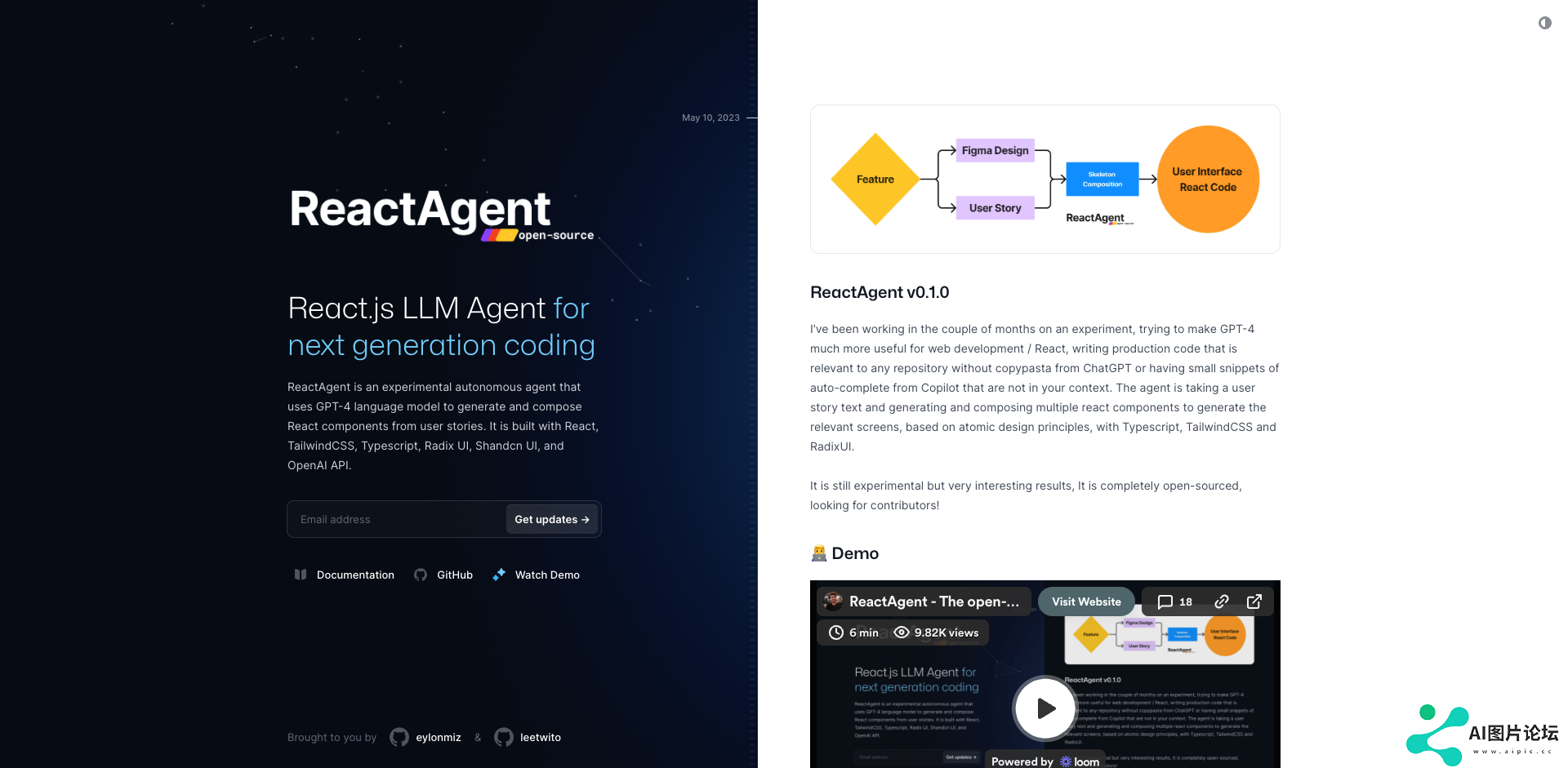

- React Agent 学习资料汇总 - 开源 React.js 自主 LLM 代理

- 1929 2025-01-03 17:08:43

-

- Mojo编程语言学习资料汇总 - 兼具Python语法和系统级性能的AI编程语言

- 1811 2025-01-06 14:37:19

相关常用工具

查看更多- 1 cheetah 1459

- 2 SUPIR 720

- 3 Conference-Acceptance-Rate 1771

- 4 DouZero 325

- 5 GodMode 518

- 6 MeloTTS 710

- 7 codefuse 1761

- 8 腾讯云 AI 代码助手 861

- 9 CodeGeeX 1311