实时语音克隆技术:5秒内复制声音的革命性突破

556 2024-12-18 00:00:00实时语音克隆:人工智能的新前沿

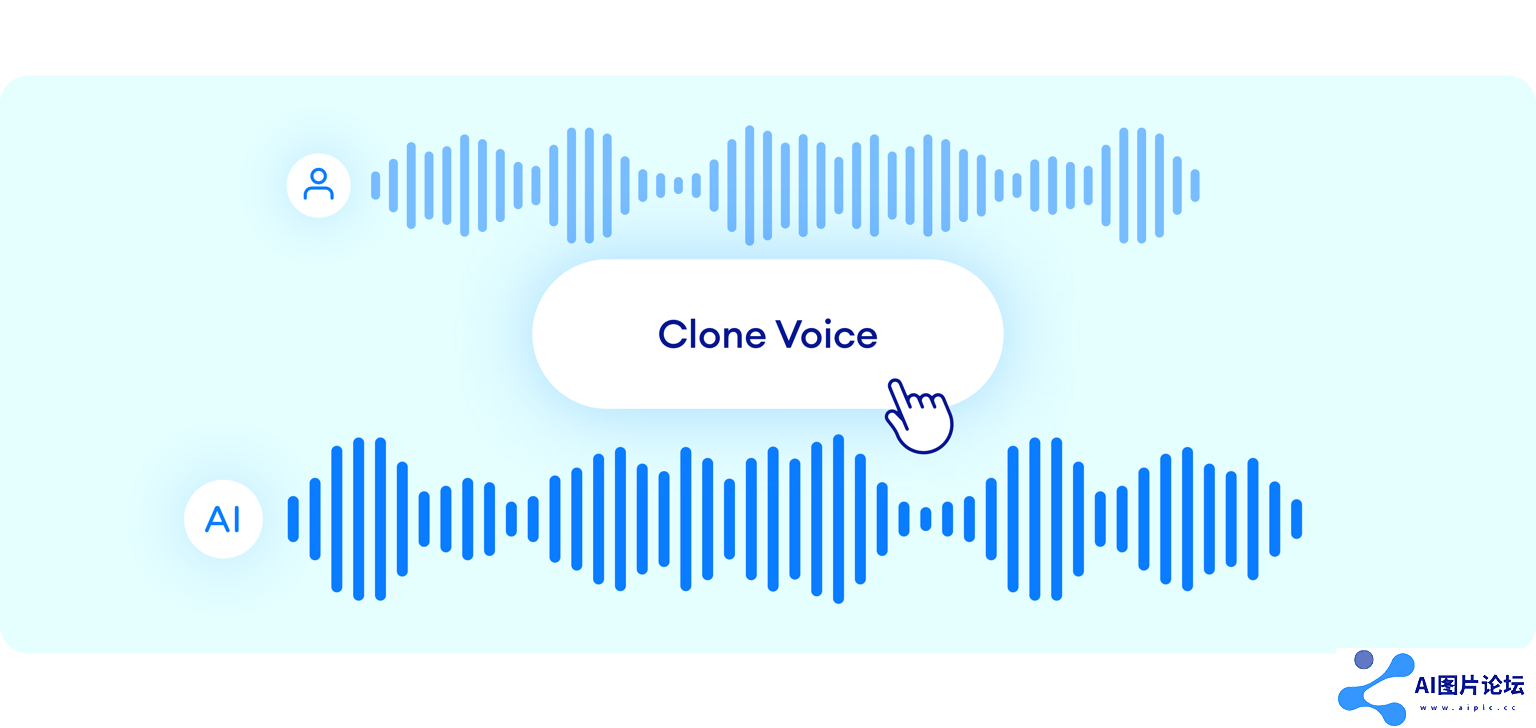

在人工智能和语音技术飞速发展的今天,一项名为Real-Time-Voice-Cloning的开源项目正在引起广泛关注。这个由Corentin Jemine开发的项目,能够在短短5秒内克隆一个人的声音,并用这个声音说出任何文本内容。这项技术不仅展示了AI在语音合成领域的巨大潜力,也为未来的语音应用开辟了新的可能性。

项目概述与技术原理

Real-Time-Voice-Cloning项目是对《从说话人验证到多说话人文本到语音合成的迁移学习》(SV2TTS)论文的实现。该项目采用了一个三阶段的深度学习框架:

编码器(Encoder):从几秒钟的音频中创建说话人的数字表示。合成器(Synthesizer):使用编码器生成的声音表示作为参考,生成梅尔频谱图。声码器(Vocoder):将梅尔频谱图转换为可听的波形。这种方法的独特之处在于它能够快速适应新的声音,而无需大量训练数据。

技术实现与创新

项目采用了多个先进的机器学习模型:

SV2TTS:用于从说话人验证到多说话人文本到语音合成的迁移学习。WaveRNN:一种高效的神经音频合成模型,用作声码器。Tacotron:一种端到端的语音合成系统,用作合成器。GE2E(Generalized End-to-End Loss):用于说话人验证的损失函数,在编码器中使用。这些模型的结合使得系统能够快速学习新的声音特征,并生成高质量的合成语音。

应用前景与潜在影响

实时语音克隆技术的出现,为多个领域带来了革命性的变化:

娱乐产业:可用于电影配音、游戏角色声音定制等。教育领域:个性化语音助手,提升学习体验。辅助技术:帮助失声者恢复"声音"。客户服务:创建个性化的AI客服声音。然而,这项技术也引发了一些伦理和安全方面的担忧,如身份欺骗和隐私问题。

项目现状与未来发展

尽管Real-Time-Voice-Cloning项目展示了令人印象深刻的技术,但开发者Corentin Jemine也坦言,随着深度学习领域的快速发展,该项目已经显得有些过时。目前,许多商业应用和其他开源项目可能提供更好的音频质量。

对于寻求高质量开源语音克隆解决方案的人来说,以下是一些推荐:

CoquiTTS:提供更好的语音克隆质量和更多功能。MetaVoice-1B:一个大型语音模型,具有高语音质量。此外,paperswithcode网站上还列出了语音合成领域的最新研究和开源项目。

使用指南

对于想要尝试Real-Time-Voice-Cloning项目的开发者,以下是一些基本步骤:

安装要求:

支持Windows和Linux系统推荐使用Python 3.7安装ffmpeg用于音频文件处理安装PyTorch和其他依赖项下载预训练模型(可选)

测试配置:运行python demo_cli.py进行测试

下载数据集(可选):推荐下载LibriSpeech/train-clean-100数据集

启动工具箱:运行python demo_toolbox.py -d

结语

Real-Time-Voice-Cloning项目虽然可能不再是语音克隆领域的最前沿,但它无疑为这一技术的发展做出了重要贡献。它不仅展示了AI在语音合成方面的潜力,也为后续研究提供了宝贵的基础。随着技术的不断进步,我们可以期待看到更多令人惊叹的语音克隆应用,这些应用将继续改变我们与技术交互的方式。

然而,在拥抱这项技术带来的机遇的同时,我们也需要警惕其可能带来的风险,并制定相应的伦理准则和法律法规。只有这样,我们才能确保语音克隆技术在为社会带来便利的同时,也能够被负责任地使用。

未来,随着深度学习和语音处理技术的进一步发展,我们可能会看到更加精确、自然的语音克隆系统。这些系统不仅能够复制声音,还能捕捉说话者的情感和语气细节。这将为个性化人机交互、辅助沟通、创意表达等领域带来无限可能。

Real-Time-Voice-Cloning项目的开源性质也为整个AI社区做出了贡献,推动了相关技术的**化。它鼓励更多开发者和研究者参与到语音合成技术的探索中来,共同推动这一领域的创新和进步。

总的来说,实时语音克隆技术代表了AI和语音处理的一个重要里程碑。它不仅展示了技术的可能性,也为我们思考AI应用的伦理和社会影响提供了一个重要案例。随着技术的不断演进,我们期待看到更多创新应用的出现,以及它们如何塑造我们的数字未来。

热门资讯

-

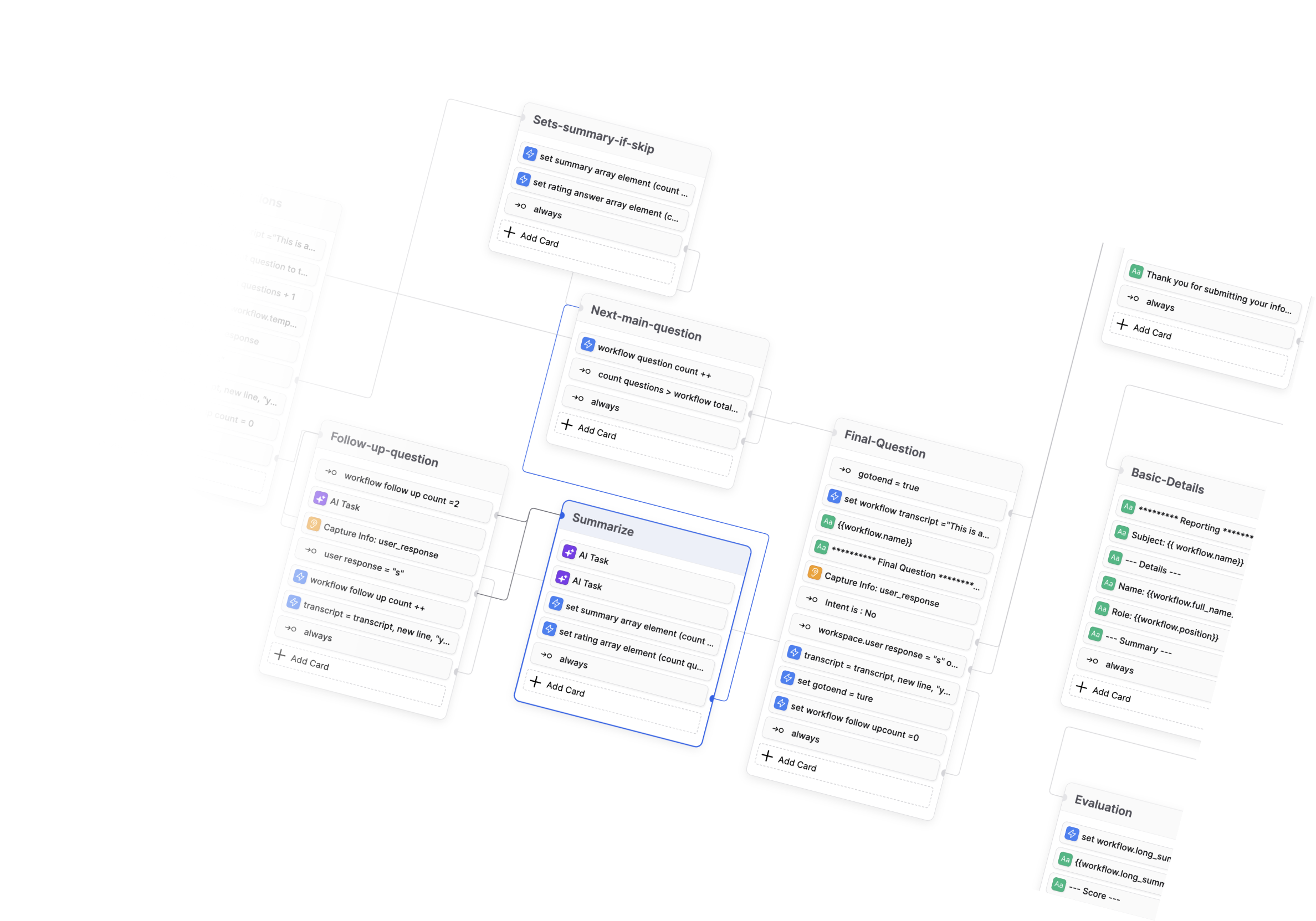

- Botpress学习资料汇总 - 开源对话式AI平台

- 1114 2024-12-16 16:31:42

-

- BibiGPT-v1: 革命性的AI音视频内容一键总结工具

- 1378 2024-12-19 05:49:31

-

- Ethora: 开源 Web3 社交平台引擎

- 955 2025-01-06 17:56:26

-

- DouZero: 基于自我对弈深度强化学习的斗地主AI系统

- 679 2024-12-19 02:10:32

-

- 开源数据工程项目精选:打造现代数据基础架构

- 1579 2025-01-06 16:16:54

-

- AI也能刷短视频了?!清华大学最新发布短视频理解模型,含图像文本音频多模态理解

- 1632 2024-12-31 16:07:01

-

- Diffree:最新模型实现文字指令修改图片!!这下修图变得更简单了

- 1482 2024-12-31 16:27:01

-

- 北大团队最新发布全景3D技术!只需一张图片和一段话就能生成全景3D场景

- 836 2024-12-31 16:46:55

-

- React Agent 学习资料汇总 - 开源 React.js 自主 LLM 代理

- 580 2025-01-03 17:08:43

-

- Mojo编程语言学习资料汇总 - 兼具Python语法和系统级性能的AI编程语言

- 877 2025-01-06 14:37:19

相关常用工具

查看更多- 1 cheetah 620

- 2 SUPIR 603

- 3 Conference-Acceptance-Rate 239

- 4 DouZero 1405

- 5 GodMode 969

- 6 MeloTTS 660

- 7 codefuse 1327

- 8 腾讯云 AI 代码助手 622

- 9 CodeGeeX 800